2023-08-19 17:46:30

El servicio de evaluación comparativa de LLM «Arthur» comparó el rendimiento de grandes modelos lingüísticos como GPT-4 para dos temas importantes.

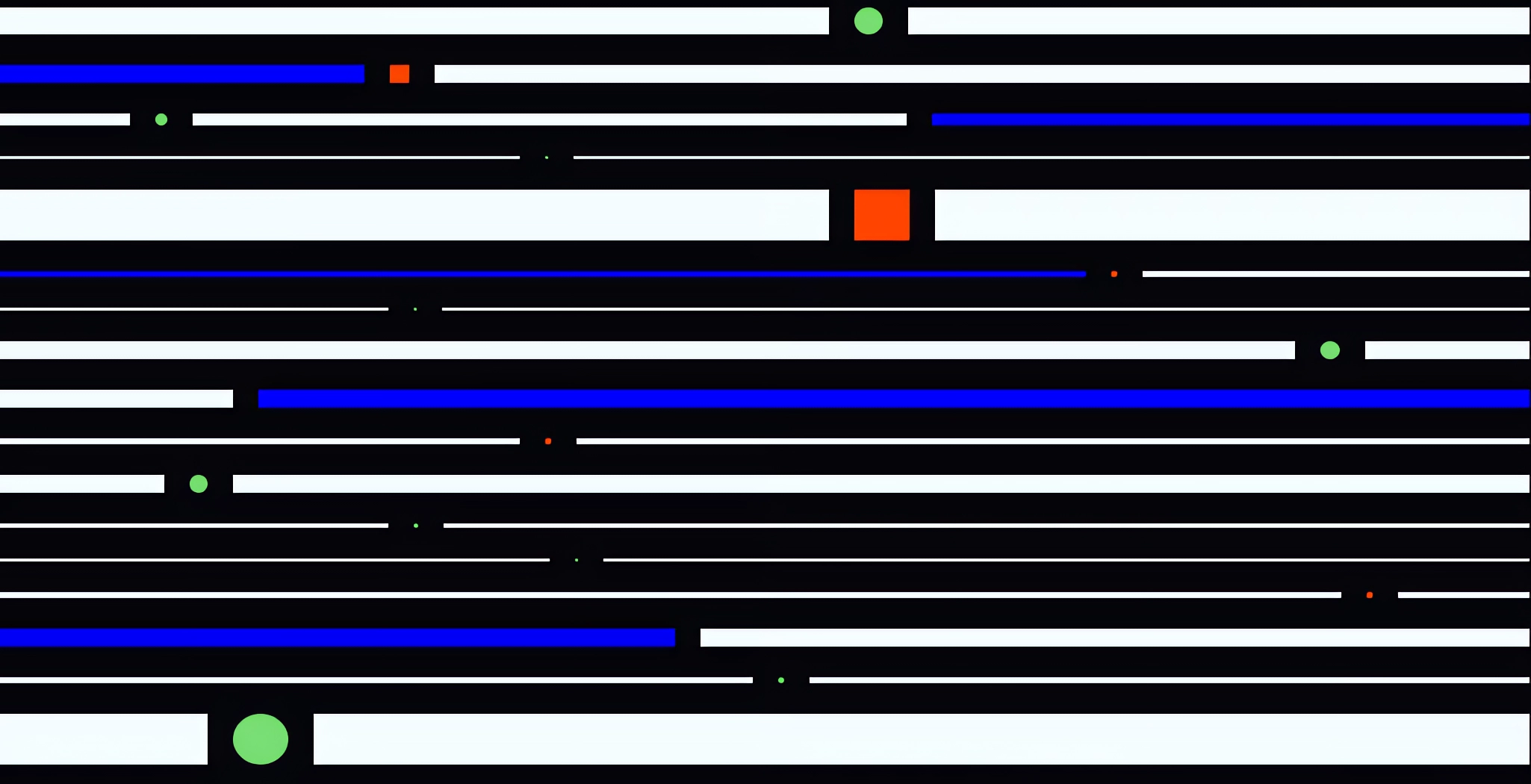

Arthur analizó las alucinaciones y relativizaciones de respuesta de los modelos de lenguaje GPT-3.5 (~175.000 millones de parámetros) y GPT-4 (~1,76 billones de parámetros) de OpenAI, Claude 2 de Anthropic (parámetros desconocidos), Llama 2 de Meta (70.000 millones de parámetros) y el modelo Command de Cohere (~50.000 millones de parámetros).

Para comparar las alucinaciones, Arthur hizo preguntas sobre combinatoria y probabilidad, presidentes de Estados Unidos y líderes políticos de Marruecos. Las preguntas se hicieron varias veces porque los LLM a veces daban la respuesta correcta, a veces una respuesta ligeramente equivocada y a veces una respuesta totalmente errónea a la misma pregunta.

Claude 2 tuvo el menor número de alucinaciones y más respuestas correctas a las preguntas sobre los presidentes de EE.UU., con un rendimiento mejor que GPT-4 y significativamente mejor que GPT-3.5 Turbo, que falló sistemáticamente. Este último es crítico porque el ChatGPT gratuito está basado en GPT-3.5 y es probablemente el más utilizado por los estudiantes y en las escuelas.

Llama 2 y Claude 2 de Meta fueron especialmente propensos a negarse a responder sobre los políticos marroquíes, probablemente como contramedida contra el exceso de alucinaciones. GPT-4 fue el único modelo con más respuestas correctas que alucinaciones en esta prueba.

GPT-4 es más prudente que otros modelos

En una segunda prueba, la plataforma de evaluación comparativa se fijó en el grado en que los modelos cubren sus respuestas, es decir, las preceden de una advertencia del tipo «Como gran modelo lingüístico, no puedo…». Esta «cobertura» de las respuestas puede frustrar a los usuarios y a veces se encuentra en textos generados por IA por «autores» descuidados.

Para la prueba de cobertura, la plataforma utilizó un de preguntas genéricas que los usuarios podrían hacer a los LLM. Los dos modelos GPT-4 utilizaron la cobertura el 3,3 y el 2,9 por ciento de las veces, respectivamente. GPT-3.5 turbo y Claude 2 lo hicieron sólo un dos por ciento de las veces, mientras que Cohere no utilizó este mecanismo.