Dolly 2.0 LLM, el primer modelo Instruction Tune completamente open source. Desarrollado por Databricks, este modelo de 12 mil millones de parámetros ha sido lanzado junto con un dataset de 15.000 ejemplos que podemos utilizar para entrenar estos modelos. Vamos a explorar en detalle qué es Dolly 2.0, cómo funciona y por qué es tan revolucionario. 🧐

🌟📚Lo que vamos a aprender:

🔍 Qué es Dolly 2.0 y cómo se relaciona con otros modelos de lenguaje como Pithia, GPT-Neo y GPT-J

💪 Las ventajas de ser un modelo Instruction Tuned y completamente open source

📈 Cómo Dolly 2.0 fue creado utilizando un dataset de 15,000 ejemplos generados por empleados de Databricks

🆚 Comparaciones con otros modelos y herramientas existentes, como Alpaca y Vicuña

📃 Las aplicaciones y casos de uso para Dolly 2.0, desde la escritura creativa hasta la clasificación y extracción de contenido

🎮 Cómo experimentar con Dolly 2.0 a través de Gradio, una plataforma interactiva para probar el modelo

🌍 La importancia de Dolly 2.0 en la democratización del acceso a la inteligencia artificial y las herramientas basadas en modelos de lenguaje

🔄 Cómo el éxito de Dolly 2.0 podría cambiar la forma en que se crean y entrenan modelos de lenguaje en el futuro

📚 Un poco de historia

Hace unas semanas, Databricks lanzó Dolly, un modelo de lenguaje basado en GPTJ, un modelo libre. Sin embargo, el dataset utilizado para hacerle el fine tuning (GPT-4) tenía restricciones en los términos y condiciones que impedían su uso comercial. 😢

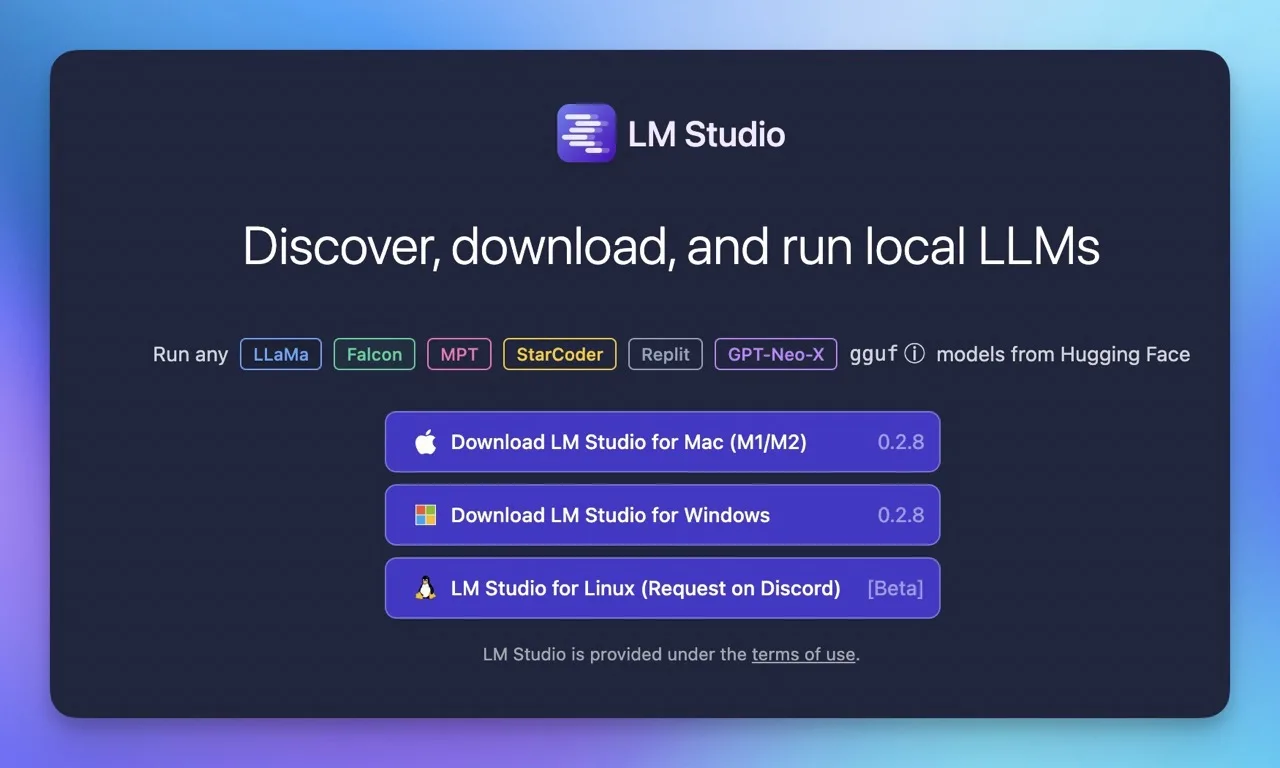

Para solucionar este problema, Databricks desarrolló Dolly 2.0, basándose en un modelo llamado Pithia. Este modelo fue entrenado por Eloiter AI, la misma empresa detrás de GPT-Neo y GPT-J. La idea era crear un modelo de lenguaje completamente open source y sin limitaciones de licencia. 🆓

🎓 El proceso de fine tuning

El fine tuning consiste en tomar un modelo de lenguaje base y modificarlo para que pueda generar respuestas más acorde a lo que queremos. En el caso de Dolly 2.0, Databricks generó un dataset de 15.000 ejemplos con la ayuda de sus empleados, quienes trabajaron en estos ejemplos durante marzo y abril de 2023. Estos ejemplos abarcan 7 tipos de casos de uso: preguntas abiertas, preguntas cerradas, extracción de contenido de Wikipedia, resumen de contenido de Wikipedia, brainstorming, clasificación y escritura creativa. 📝

🌟 Ventajas de Dolly 2.0

- Dataset de 15.000 ejemplos gratuito: Este dataset tiene una licencia que nos permite hacer lo que queramos con él, como traducirlo a otros idiomas o crear el primer dataset de Instruction Fine Tuning completamente open source en español.

- Modelo basado en Pythia de 12 mil millones de parámetros: Este modelo es completamente libre y se encuentra en Hugging Face.

📊 ➡️ Tabla de datos principales, estadísticas y capacidades de Dolly 2.0:

- Modelo: Dolly 2.0

- Tipo de modelo: Instruction Tuned

- Naturaleza: Open Source

- Modelo base: Pythia (12 mil millones de parámetros)

- Entrenado por: Databricks

- Dataset: 15.000 ejemplos

- Fecha de generación del dataset: marzo y abril de 2023 (6 semanas aproximadamente)

- Licencia: Completamente libre para uso comercial y personal

- Casos de uso: Preguntas abiertas, preguntas cerradas, sacar contenido de Wikipedia, resumir contenido de Wikipedia, brainstorming, clasificar y escritura creativa

- Limitaciones de modelos similares: Alpaca, vicuña, etc., todos tienen limitaciones en la licencia, prohibiendo el uso comercial

- Relación con otros modelos: GPT-Neo, GPT-J (Eleuther AI) y modelos de Hugging Face

Metodología de entrenamiento:

- Paso 1: Supervised Fine Tuning (Entrenamiento supervisado)

- Uso de un dataset de 15.000 ejemplos generados por empleados de Databricks, con 7 tipos de casos de uso

- Dataset completamente gratuito y con licencia que permite su modificación y adaptación a otros idiomas o fines

- Método de entrenamiento alternativo: DeepSpeedChat (Microsoft) – RLHF (Reinforcement Learning de Human Feedback)

Ejemplos de preguntas y respuestas en el dataset:

- ¿Cuándo empezó a operar Virgin Australia?

- Contexto: Virgin Australia (información de Wikipedia)

- Respuesta: 2000

- Categoría: Question Answer

- Los padres de Alicia tienen tres hijas, Amy, Jessie y ¿cuál es el nombre de la tercera hija?

- Contexto: No se proporciona

- Respuesta: Alicia

- Categoría: Preguntas abiertas

- ¿Cuál de estos dos es una especie de pescado? Taupe o Rope

- Contexto: No se proporciona

- Respuesta: Taupe

- Categoría: Clasificación

🎮 Demostración de Dolly 2.0

Vamos a ver algunos ejemplos de cómo funciona Dolly 2.0 en acción. 💡

🏕️ Cómo construir un fuego en el exterior

Aquí, le pedimos al modelo que nos dé instrucciones para construir un fuego en el exterior. El modelo nos proporciona una respuesta detallada y útil, mostrando su capacidad para generar contenido relevante y preciso. 🔥

🥪 Ideas para sándwiches con mantequilla de maní

En este caso, solicitamos cinco ideas para combinar mantequilla de maní en un sándwich. El modelo nos proporciona varias opciones creativas y deliciosas, demostrando su habilidad para realizar brainstorming y generar contenido innovador. 🍞

Entonces, ¿cómo funciona realmente Dolly 2.0 y qué lo hace especial? 🤔

Bueno, primero debemos entender que Dolly 2.0 es un modelo de lenguaje basado en el modelo Pithia, que fue entrenado por EleutherAI, el mismo equipo detrás de GPT-Neo y GPT-J 🚀. Al ser el primer modelo Instruction Tuned completamente open source, es una herramienta poderosa y accesible para todo tipo de usuarios, desde investigadores hasta desarrolladores y empresas.

Dolly 2.0 fue creado utilizando un dataset de 15.000 ejemplos generados por empleados de Databricks, lo que le permite ofrecer respuestas precisas y útiles en diferentes casos de uso, como preguntas abiertas, preguntas cerradas, extracción de contenido de Wikipedia, resumen de contenido de Wikipedia, brainstorming, clasificación y escritura creativa 🎨.

Pero, ¿cómo se compara con otros modelos y herramientas existentes?

A diferencia de Alpaca, Vicuña y otros modelos, Dolly 2.0 no tiene limitaciones en su licencia, lo que significa que se puede utilizar de manera comercial, sin infringir los términos y condiciones de OpenAI. Esto abre un mundo de posibilidades para quienes buscan implementar soluciones basadas en inteligencia artificial en sus productos y servicios 🌐.

Para demostrar cómo funciona Dolly 2.0 en acción, Databricks ha lanzado un espacio de Gradio 🎛️ donde los usuarios pueden experimentar y probar el rendimiento del modelo en diferentes situaciones. A través de este espacio, es posible ver cómo Dolly 2.0 responde a preguntas y solicitudes de manera efectiva y precisa, ofreciendo información relevante y útil según las necesidades del usuario.

¿qué significa todo esto para el futuro de los modelos de lenguaje y la inteligencia artificial en general?

La llegada de Dolly 2.0 representa un paso importante hacia la democratización del acceso a la inteligencia artificial y a las herramientas basadas en modelos de lenguaje. Al ser un modelo completamente open source, permite a los usuarios de todo el mundo aprovechar su poder para crear soluciones innovadoras y útiles en diversos campos 🌍.

Además, el éxito de Dolly 2.0 demuestra que es posible generar datasets de alta calidad utilizando recursos internos, como los empleados de una empresa. Esta práctica podría cambiar la forma en que las empresas y los desarrolladores crean y entrenan modelos de lenguaje en el futuro, ofreciendo una alternativa viable a los datasets cerrados y restringidos que actualmente dominan el mercado 📊.

En resumen, Dolly 2.0 es un avance emocionante en el mundo de la inteligencia artificial y los modelos de lenguaje, que ofrece un modelo potente, efectivo y completamente accesible para todos. Con su rendimiento impresionante y su licencia abierta, Dolly 2.0 está preparado para cambiar la forma en que abordamos las soluciones basadas en inteligencia artificial, abriendo un mundo de posibilidades para la innovación y el crecimiento en múltiples sectores 🚀💡.

Así que, ya sea que estés buscando implementar soluciones de inteligencia artificial en tu negocio o simplemente quieras experimentar con el poder de los modelos de lenguaje, Dolly 2.0 es una herramienta

⚠️🚨 Limitaciones Conocidas

Limitaciones de rendimiento

Dolly-v2-12b no es un modelo generativo de lenguaje de última generación y, aunque la evaluación comparativa cuantitativa está en curso, no está diseñado para competir con arquitecturas de modelo más modernas o modelos sujetos a corpus de preentrenamiento más grandes.

La familia de modelos Dolly está en desarrollo activo, por lo que cualquier lista de deficiencias es poco probable que sea exhaustiva, pero incluimos limitaciones y fallos conocidos aquí como un medio para documentar y compartir nuestros hallazgos preliminares con la comunidad. En particular, dolly-v2-12b tiene problemas con: indicaciones sintácticamente complejas, problemas de programación, operaciones matemáticas, errores factuales, fechas y horas, respuestas a preguntas abiertas, alucinaciones, enumeración de listas de longitud específica, imitación estilística, tener sentido del humor, etc. Además, encontramos que dolly-v2-12b no tiene algunas capacidades, como la escritura de cartas bien formateadas, presentes en el modelo original.

Limitaciones del conjunto de datos

Como todos los modelos de lenguaje, dolly-v2-12b refleja el contenido y las limitaciones de sus corpus de entrenamiento.

The Pile: El corpus de preentrenamiento de GPT-J contiene contenido recopilado principalmente de internet público y, como la mayoría de los conjuntos de datos a gran escala, contiene contenido que muchos usuarios encontrarían objetable. Como tal, es probable que el modelo refleje estas deficiencias, posiblemente de manera explícita en caso de que se le pida específicamente que produzca contenido objetable, y a veces de manera sutil, como en el caso de asociaciones implícitas sesgadas o perjudiciales.

databricks-dolly-15k: Los datos de entrenamiento en los que dolly-v2-12b está sintonizado por instrucción representan instrucciones de lenguaje natural generadas por empleados de Databricks durante un período que abarca marzo y abril de 2023 e incluye pasajes de Wikipedia como pasajes de referencia para categorías de instrucción como preguntas y respuestas cerradas y resúmenes. Hasta donde sabemos, no contiene obscenidades, propiedad intelectual o información personal identificable sobre personas no públicas, pero puede contener errores tipográficos y factuales. El conjunto de datos también puede reflejar sesgos encontrados en Wikipedia. Finalmente, es probable que el conjunto de datos refleje los intereses y elecciones semánticas de los empleados de Databricks, una demografía que no es representativa de la población mundial en general.

Databricks se compromete a esfuerzos continuos de investigación y desarrollo para desarrollar tecnologías de IA útiles, honestas e inofensivas que maximicen el potencial de todos los individuos y organizaciones.

Métricas de referencia

A continuación, encontrarás el rendimiento de referencia de varios modelos en el EleutherAI LLM Evaluation Harness; los resultados del modelo se ordenan según la media geométrica para producir un ordenamiento comprensible. Como se describió anteriormente, estos resultados demuestran que dolly-v2-12b no es de última generación y, de hecho, tiene un rendimiento inferior a dolly-v1-6b en algunas evaluaciones comparativas. Creemos que esto se debe a la composición y tamaño de los conjuntos de datos de ajuste fino subyacentes, pero se requiere un estudio adicional para determinar las fuentes de estas variaciones.